MaxCompute湖倉一體近實時增量處理技術架構揭秘

隨著大數據和云計算技術的快速發展,企業數據處理需求日益復雜,對數據處理的時效性、靈活性和成本效益提出了更高要求。阿里云MaxCompute作為領先的數據處理平臺,結合湖倉一體(Lakehouse)架構,推出了近實時增量處理技術,為企業數據處理服務帶來了革命性的提升。本文將從技術架構、核心組件與數據處理流程三個方面,深入揭秘MaxCompute湖倉一體的近實時增量處理技術。

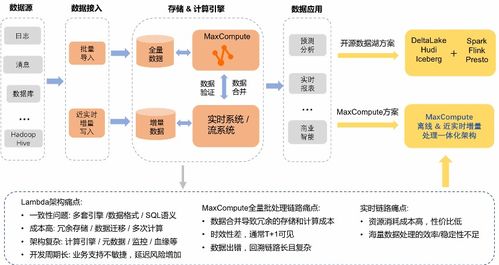

一、技術架構概述

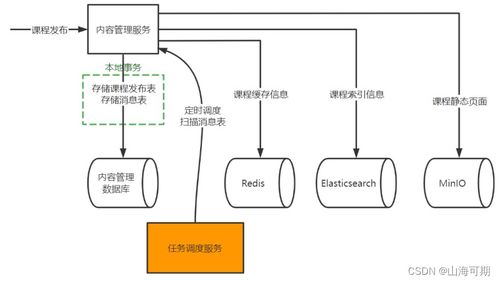

MaxCompute湖倉一體架構融合了數據湖的靈活性和數據倉庫的高性能,支持結構化、半結構化和非結構化數據的統一存儲與處理。近實時增量處理技術是該架構的核心之一,它通過流批一體、增量更新和事務一致性機制,實現了數據從產生到分析的低延遲處理。架構主要包括數據源層、接入層、存儲層、計算層和服務層:

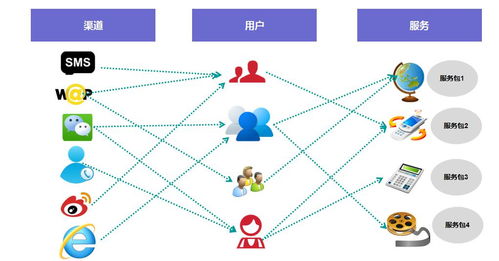

- 數據源層:支持多種數據源,如數據庫日志、IoT設備、應用程序事件等,通過CDC(Change Data Capture)或消息隊列(如Kafka)實時捕獲增量數據。

- 接入層:采用MaxCompute Tunnel或DataHub服務,實現數據的快速接入和緩沖,確保數據高效流入存儲層。

- 存儲層:基于對象存儲(如OSS)構建統一數據湖,同時利用MaxCompute的表存儲格式(如ORC、Parquet)優化數據組織,支持ACID事務和增量快照。

- 計算層:通過MaxCompute SQL、Spark或Flink引擎,實現流批混合計算,自動處理增量數據,并提供近實時查詢能力。

- 服務層:為上層應用提供數據API、數據服務和可視化工具,支持實時報表、機器學習和業務分析。

二、核心組件與技術特點

MaxCompute近實時增量處理技術的成功依賴于多個核心組件:

- 增量數據捕獲:使用Debezium或自定義CDC工具,從源系統捕獲數據變更事件,確保數據完整性和低延遲。

- 流式處理引擎:集成Flink或Spark Streaming,處理實時數據流,支持窗口計算、狀態管理和容錯機制。

- 統一元數據管理:通過Hive Metastore或MaxCompute內置元數據服務,實現數據湖和倉庫的元數據一致性,簡化數據發現和治理。

- 增量合并與優化:采用Delta Lake或Iceberg等開源表格式,支持增量數據的合并、壓縮和版本控制,減少存儲冗余并提升查詢性能。

- 事務保障:基于多版本并發控制(MVCC)和快照隔離,確保在并發場景下數據的一致性和可靠性。

技術特點包括:

- 近實時處理:數據從產生到可查詢的延遲可控制在分鐘級,滿足業務對時效性的需求。

- 成本效益:通過增量處理減少全量計算,降低資源消耗和成本。

- 靈活性:支持多種數據格式和計算引擎,便于企業根據場景選擇最佳方案。

- 易用性:提供SQL接口和可視化工具,降低開發門檻,提升數據處理效率。

三、數據處理流程與實戰應用

在實際應用中,MaxCompute湖倉一體的近實時增量處理技術廣泛應用于電商、金融、物聯網等領域。典型數據處理流程如下:

- 數據采集:從業務數據庫(如MySQL)通過CDC工具捕獲增量數據,并發送到消息隊列。

- 數據接入:使用DataHub或Tunnel服務將數據接入MaxCompute存儲層,存儲在數據湖中。

- 增量計算:通過Flink作業處理實時數據流,進行數據清洗、轉換和聚合,結果寫入增量表。

- 數據服務:利用MaxCompute的查詢引擎,提供近實時數據分析,并通過DataWorks或Quick BI等服務輸出結果。

例如,在電商場景中,該技術可用于實時更新用戶行為數據,支持個性化推薦和庫存監控。通過增量處理,企業能夠快速響應市場變化,提升業務敏捷性。

MaxCompute湖倉一體的近實時增量處理技術通過創新的架構設計和核心組件,實現了數據處理的高效、實時和統一。它不僅降低了數據管理的復雜性,還為企業提供了強大的數據處理服務,助力數字化轉型。隨著AI和邊緣計算的融合,這一技術將進一步演進,滿足更廣泛的數據處理需求。

如若轉載,請注明出處:http://www.zpshuidi.cn/product/20.html

更新時間:2026-01-11 02:47:04