千萬QPS毫秒響應 快手數據中臺建設中的數據處理服務實踐

在短視頻與直播行業迅猛發展的浪潮中,快手作為領先的內容社區,面臨著海量用戶行為數據實時處理與分析的巨大挑戰。為支撐業務的飛速創新與增長,快手構建了以“千萬級每秒查詢率(QPS)與毫秒級響應”為核心目標的數據中臺,其數據處理服務實踐成為了業界關注的焦點。

一、 核心挑戰與架構目標

快手的數據洪流主要源自視頻播放、互動、社交、直播打賞等場景,其特點在于數據量極大、產生速度極快、且業務對數據新鮮度與查詢性能要求極高。傳統批處理與高延遲的查詢架構已無法滿足推薦系統實時調控、風控即時決策、運營實時洞察等需求。因此,快手數據中臺的建設確立了明確目標:構建一個能夠穩定處理每秒千萬級請求,并在復雜查詢下實現毫秒級響應的統一數據處理與服務層。

二、 數據處理服務的核心架構實踐

為實現上述目標,快手的數據處理服務采用了分層、融合的技術架構:

- 流批一體的數據攝入與計算層:采用Apache Flink作為核心計算引擎,統一處理實時流數據與微批數據。通過定制化優化Flink的狀態管理、網絡傳輸與Exactly-Once語義保證,使其能夠高效處理每秒數十億條的消息流,為下游提供低延遲(百毫秒級)的實時數據快照與聚合結果。與離線計算鏈路打通,確保數據口徑的一致性與靈活性。

- 高性能分布式存儲與查詢引擎:針對不同的數據訪問模式,混合選用多種存儲與查詢技術。

- 對于需要極低延遲點查(如用戶畫像實時查詢),深度優化了分布式鍵值(KV)存儲系統,結合智能緩存、內存池化與RDMA網絡技術,將P99延遲壓至毫秒級。

- 對于復雜的即席查詢與多維分析,則基于Apache Doris或ClickHouse等MPP數據庫構建實時數倉,通過預聚合、智能索引、數據分層(熱溫冷)等手段,在萬億數據規模下實現亞秒級響應。

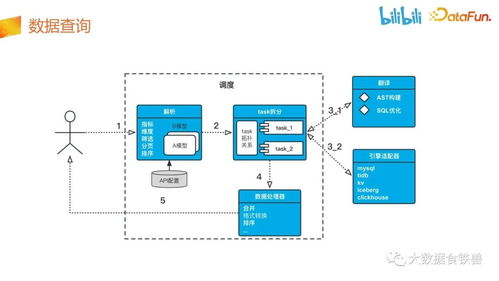

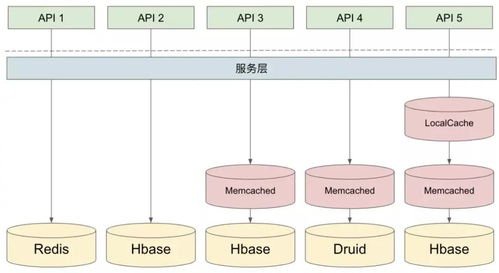

- 統一服務化與智能網關:將底層多樣的數據能力(實時指標、用戶標簽、行為事件等)封裝成標準的、高性能的API服務。通過構建統一的智能數據服務網關,實現服務的自動注冊發現、負載均衡、熔斷降級、監控告警以及統一的鑒權與流量治理。網關層面進行請求的智能路由與聚合,將多個數據點的查詢合并,減少網絡往返,進一步降低客戶端感知延遲。

- 資源調度與穩定性保障:數據處理服務全面部署在云原生Kubernetes平臺上,實現計算與存儲資源的彈性伸縮。通過完善的監控體系(涵蓋QPS、延遲、錯誤率、資源利用率等)和自動擴縮容策略,從容應對流量洪峰。建立了從數據鏈路血緣追蹤到服務依賴治理的全鏈路可觀測性體系,確保問題能夠快速定位與恢復。

三、 關鍵優化與創新點

- 數據局部性優化:將計算任務盡可能調度到靠近存儲節點的位置,并利用SSD與內存分級存儲熱數據,大幅減少數據網絡傳輸開銷。

- 向量化執行與編譯優化:在查詢引擎中廣泛采用向量化處理與即時編譯(JIT)技術,最大化利用現代CPU的并行處理能力。

- 異步化與全鏈路并行:從數據攝入、處理到服務響應,全鏈路采用異步非阻塞設計,避免線程阻塞,提高系統整體吞吐。

四、 成效與展望

通過上述實踐,快手的數據處理服務成功支撐了平臺核心業務的實時數據需求,在“618”、“春晚”等超大流量場景下保持了服務的堅如磐石。千萬級QPS與毫秒級響應的實現,不僅提升了用戶體驗,更驅動了業務決策從“天級”向“秒級”的跨越。快手將繼續探索基于新硬件(如持久內存、智能網卡)的加速、AI for Data系統的自治運維以及更智能的數據服務編排,推動數據中臺向更實時、更智能、更易用的方向演進。

快手的數據處理服務建設實踐表明,應對超大規模實時數據挑戰,需要的是一個融合流批、統一服務、軟硬協同、并具備極致彈性與穩定性的系統性工程,這為行業構建高性能數據中臺提供了寶貴的參考范式。

如若轉載,請注明出處:http://www.zpshuidi.cn/product/44.html

更新時間:2026-01-11 17:52:28